Mieux comprendre ChatGPT, la nouvelle IA conversationnelle d'OpenAI

Vous avez sûrement entendu parler du phénomène qui impressionne et fait beaucoup parler ces dernières semaines : ChatGPT. Son objectif : répondre aux sollicitations sur un maximum de sujets en générant des réponses de manière autonome. Le petit nouveau d’OpenAI fait suite à d’autres modèles ayant également animés les foules comme notamment DALL-E et sa création d’image par commande textuelle.

Quoi penser de ces intelligences artificielles et en particulier de ChatGPT ? Quels sont ses usages et ses limites ?

Qu'est-ce que c'est ChatGPT ?

Initialement, OpenAI était une association américaine. Elle a été lancée en 2015 par Elon Musk et Sam Altman. Cette association, qui est à présent une entreprise depuis mars 2019, est à l’origine de nombreux modèles tous plus connus les uns que les autres comme notamment GPT-2, GPT3, DALL-E et chatGPT. OpenAI propose l’accès à de nombreux outils et tâches en traitement du langage via son API pour de l’entraînement, du fine-tuning ou de l’inférence* sur les modèles non entraînés ou pré-entraînés.

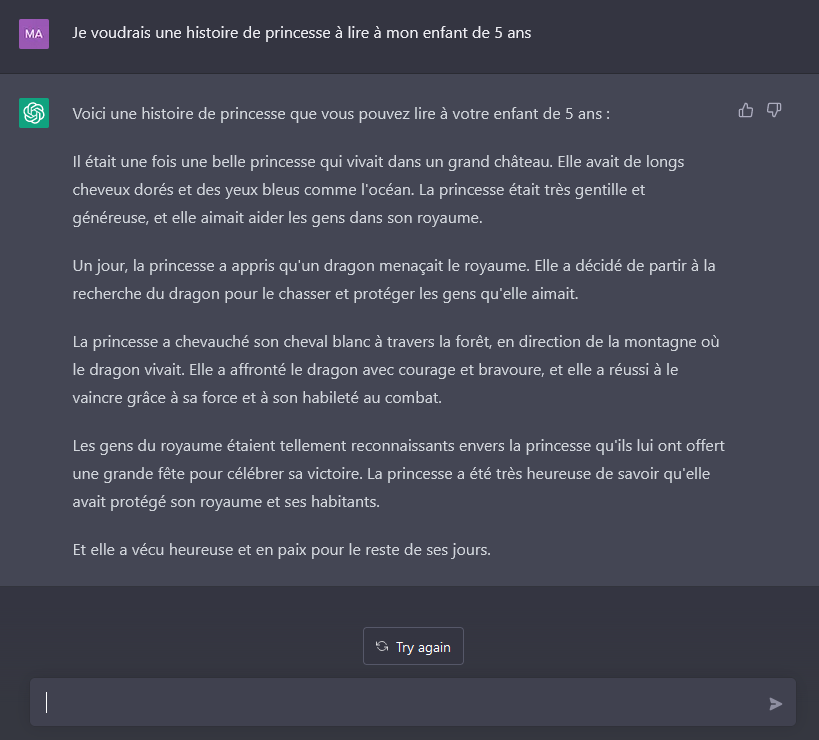

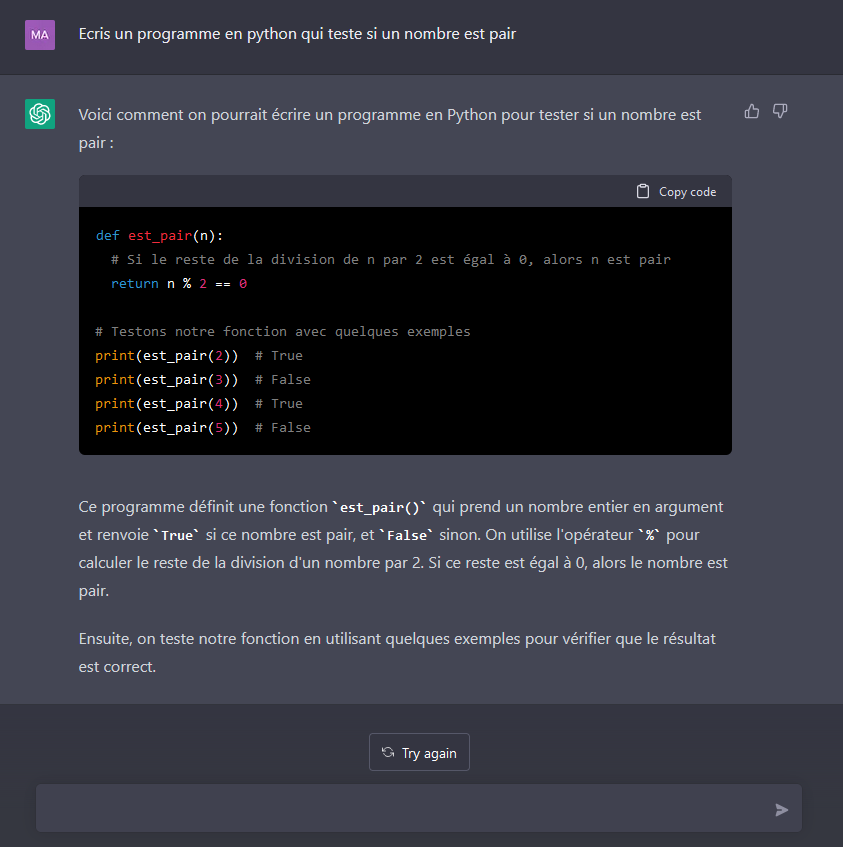

ChatGPT est un agent conversationnel avec qui il est possible d’échanger par écrit. Il est capable de répondre à des questions très variées. Il a pour but de se rapprocher d’une conversation humaine en répondant en langage naturel et il est également capable de produire du contenu comme du code, des articles, des histoires, des lettres, etc.

Si l'usage de ChatGPT s'est démocratisé ou sera implémenter dans votre entreprise, il peut être intéressant de mettre en place une charte d'utilisation de ChatGPT pour encadrer l'utilisation de l'outil.

L’engouement autour de ChatGPT peut se comprendre. Tout d’abord, la communauté autour d’OpenAI est massive et très investie dans la recherche et l’utilisation de nouvelles technologies grandement novatrices. Ensuite, la tâche conversationnelle est une tâche complexe en intelligence artificielle. Bien que les agents conversationnels virtuels soient de plus en plus répandus et qu’ils s’améliorent largement au fur et à mesure des années, ils trainent derrière eux une réputation assez déceptive et des conversations que certains décrivent comme limitées ou peu naturelles. Dans ce contexte, les résultats de ChatGPT sont d’autant plus impressionnants !

Pour les non-initiés, il est donc facile d’être bluffé par la pertinence et la justesse des réponses apportées ou du contenu produit suivant la demande. Cependant, même les personnes du domaine, qui sont bien au fait des difficultés liées à ce type d’application, sont agréablement surprises.

Comme son nom l’indique, ChatGPT est basé sur le modèle de langage GPT, plus précisément GPT-3. Ce dernier est un modèle de représentation du langage pré-entraîné sur des centaines de milliards de mots comprenant près de 170 milliards de paramètres. Il est capable d’analyser et de générer du texte dans différentes langues et différents langages de programmation. ChatGPT comprend ensuite plusieurs phases d’entraînement :

Le modèle GPT-3 est fine-tuné sur un ensemble de conversations rédigées par des humains en charge d’imiter des conversations dans lesquelles ils jouent le rôle de l’utilisateur et de l’assistant répondant aux questions. Cette phase constitue donc un premier apprentissage supervisé du modèle.

Ensuite, un modèle de récompense est entraîné. Pour une demande donnée, plusieurs propositions de réponses sont faites. Un humain ordonne les réponses par pertinence, ce qui constitue la récompense du modèle. Cette phase est une nouvelle étape d’apprentissage.

Finalement, l’algorithme d’apprentissage par renforcement est appliqué. Le fonctionnement s’appuie sur l’apprentissage humain, c’est à dire apprendre de ses expériences et des récompenses que l’on en tire. Pour une demande donnée, une réponse est générée, puis une récompense est calculée grâce au modèle dédié. La récompense permet de mettre à jour le modèle au fur et à mesure de cette étape de renforcement.

Qu’est-ce que ChatGPT est capable de faire, à quoi sert cet outil ?

Il y a énormément de cas d’utilisation envisageables pour ChatGPT. En réalité, on pourrait imaginer l’utiliser pour chaque application où un utilisateur aurait besoin d’information. L’accès à cette information serait possible non plus via une recherche, comme actuellement, mais simplement par une demande explicitée en langage naturel.

Aussi, et contrairement à d’autres intelligences artificielles conversationnelles, le modèle ChatGPT semble mieux paramétré quant aux propos inappropriés (propos haineux, etc.). Il est donc, dans une certaine mesure, capable d’échanger sur divers sujets sans franchir de limites morales dérangeantes. Cela tient principalement au fait que les conversations sur lesquelles est entraîné ChatGPT sont rédigées par des humains, le contenu est donc en partie contrôlé ou du moins révisé. Cependant, OpenAI met bien en garde les utilisateurs sur le fait que le déroulé des conversations ne soit pas modéré, il faut donc rester vigilant.

Quelles sont ses limites de chatGPT ?

Les limites sont celles posées par la machine : comme évoqué plus haut, ChatGPT ne peut pas avoir des connaissances sur tous les sujets, il ne connait que l’information qu’on lui a donné. Sa connaissance repose sur la quantité de données qui lui a été présentée pendant l’apprentissage. Il n’est donc pas capable de faire des suppositions, des déductions tout simplement de faire preuve d’intelligence. ChatGPT ne peux donc pas répondre à des domaines très spécifiques ou nouveaux sur lesquels il n’aurait pas d’information : il doit être spécialisé en fonction de son cas d’usage, ce qui demande de gros moyens techniques et financiers.

Il faut également tester largement le modèle pour s’assurer qu’il ne répond que s’il est suffisamment sûr de la réponse à apporter. En effet, il serait souhaitable que le modèle fasse preuve de résilience et admette ses incertitudes voire ses erreurs. Aussi, pour une même question ou demande, ChatGPT n’apporte pas forcément la même réponse, ce qui peut s’avérer déroutant.

Enfin, des limites importantes sont liées à la gestion de nombreuses données. Dans l’Union Européenne et en France, nous sommes respectivement protégés par notamment l’AI Act et le RGPD mais dans ce contexte, on peut se demander où sont hébergées et comment sont traitées les informations sur les utilisateurs ainsi que les conversations obtenues.

Quelle différence entre ChatGPT et un chatbot comme le propose Wikit ?

ChatGPT utilise les informations qu’on lui a fourni pour générer ses réponses mais n’aura jamais la précision requise pour répondre à des sollicitations ciblées, à des questions sur un domaine d’expertise défini comme le propose un assistant intelligent comme le nôtre. On le voit notamment dans l’exemple médical cité plus haut : il est bien plus avisé de faire appel à un chatbot spécialisé capable de comprendre des requettes plus pointues et en lien avec votre organisation.

Il faut impérativement passer par une relecture complète des éléments de réponse du chatbot afin de garantir sa pertinence accrue mais aussi s’assurer qu’absolument aucun débordement ne pourrait advenir. En effet, si les réponses ne sont pas pré-définies et validées en amont mais générées, rien n’empêche un entrainement biaisé voire malveillant qui pourrait ainsi mener à des réponses contenant des propos inappropriés, ce qui aurait des conséquences très problématiques.

Découvrez quels bénéfices vous pourriez tirer du couplage de chatGPT et d'un QA bot sur mesure au sein de votre organisation

En bref

ChatGPT est une nouvelle avancée dans le domaine de l’intelligence artificielle et offre de nombreuses possibilités. Grâce à l’énorme investissement financier et aux moyens déployés conséquents, le résultat est impressionnant. Attention cependant à faire la part des choses et à ne pas voir en ce modèle, qui reste privé, une révolution mondiale rebattant les cartes du conversationnel.

Tout d’abord, on pourrait imaginer ce modèle concurrencer les moteurs de recherches actuels mais pas remplacer un assistant intelligent spécialisé aux nuances et particularités d’un domaine. Aussi, son utilisation à grande échelle pour tout type de domaine poserait une question écologique due à son grand nombre de données à stocker, traiter, analyser.

*L’inférence est la partie du traitement qui consiste à prédire un résultat à partir d’un modèle entraîné.

**Le fine-tuning consiste à utiliser un modèle déjà entraîné sur une tâche et à le spécialiser sur une nouvelle. Généralement, on utilise cette technique pour profiter de connaissances générales acquises pendant un premier entraînement et bénéfiques à la nouvelle tâche. Cette technique est également économique car elle permet de mutualiser les ressources et limiter l'entraînement de nouveaux modèles de zéro.